Якими критеріями оцінки якості текстового наповнення сайтів оперує Google?

Всі пошукові системи прагнуть до того, щоб інформаційні сайти пропонували інтернет-аудиторії контент найвищої якості. При виявленні текстів, які не відповідають актуальним вимогам роботів-аналітиків, пошуковики оперативно реагують на порушення, накладаючи на ресурси різні штрафні санкції.

Аналіз якості наповнення здійснюється за допомогою широкого спектра методів і технік. Варто відзначити, що по цей час невідомо, яка саме аналітична стратегія застосовується Google на етапі дослідження вмісту сайту. Цей матеріал буде присвячений вивченню концепцій, які допоможуть вам оптимізувати контент у 2021році.

На що слід орієнтуватися?

На сьогодні Google в першу чергу оцінює такі показники сайтів:

- рівень читання контенту;

- щільність ключових слів, фраз;

- кількість рекламних матеріалів;

- швидкість завантаження, функціонування web-сторінок;

- однорідність текстового вмісту;

- мовні параметри (характеристики) статей.

Актуальні аналітичні методи 2021 року

1. Алгоритм Панда. Цей інструмент був запущений ще на початку 2011 року. З того часу Панда неодноразово оновлювалася, модифікувалася. У січні 2016 року алгоритм був включений в базовий аналітичний комплекс Google.

Мета функціонування Панди на старті – це пошук низькоякісного і малоінформативного контенту. На цей момент Панда продовжує боротися з дубльованим наповненням, спамом, проте механізм роботи алгоритму став складнішим. Це дозволяє системі проводити комплексний аналіз web-документів, а також знижувати рейтинг (позиції) сайтам, що «проштрафилися» в найкоротші терміни.

Для того, щоб не потрапити під Панду, скористайтеся наступними рекомендаціями:

- створюйте контент з максимальною технічною відсталістю та інформаційною унікальністю;

- ретельно перевіряйте написання статті на предмет наявності в них орфографічних і стилістичних помилок;

- смислова достатність контенту – параметр, який буде відслідковуватися Google у 2021 році в першу чергу.

2. Щільність ключів і наповнення, що є стовідсотковою копією змістовної структури інших тематичних текстів. Розміщення надмірної кількості ключових слів в статтях – це застаріла оптимізаційна тактика. Свого часу цей метод дозволяв сайту зайняти високі позиції в пошукових системах. Сьогодні він не працює.

Річ у тому, що насичення контенту ключами – це стратегія, спрямована не на підвищення якості інформаційного продукту, а на дотримання первинних вимог пошукових машин. Google проти застосування подібної тактики, бо вона жодним чином не сприяє поліпшенню користувацького досвіду.

Також варто пам’ятати, що система вважає низькоякісним контент, в якому присутня мінімальна кількість синонімів ключових слів з семантичного ядра (СЯ).

Дублювання змісту розміщених в мережі текстів (публікація на майданчику так званого «ванільного» контенту) надає схоже (негативний) вплив на ранжування сайтів в пошукових системах. Тексти, які характеризуються відсутністю не тільки новизни, але та оригінальною подачі матеріалу, сприймаються пошукачем як інформаційне сміття.

Розв’язання проблеми: в процесі обробки вихідних текстів з високими пошуковими рейтингами підключайте додаткові джерела інформації (інтерв’ю з нішевими експертами, відомості, взяті з новинних порталів, свіжі дані з конференцій, семінарів і так далі).

Лайфхак: для автоматизації роботи по роботі з текстами в нових реаліях, рекомендую використовувати новий функціонал «Текстова аналітика» від Serpstat.

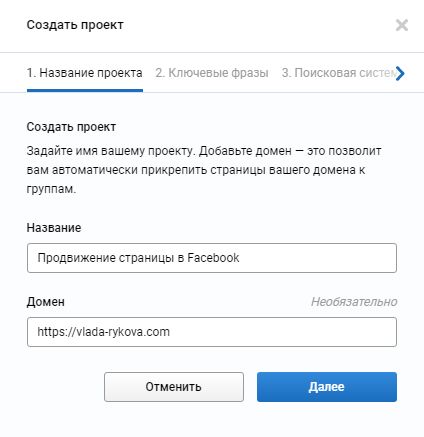

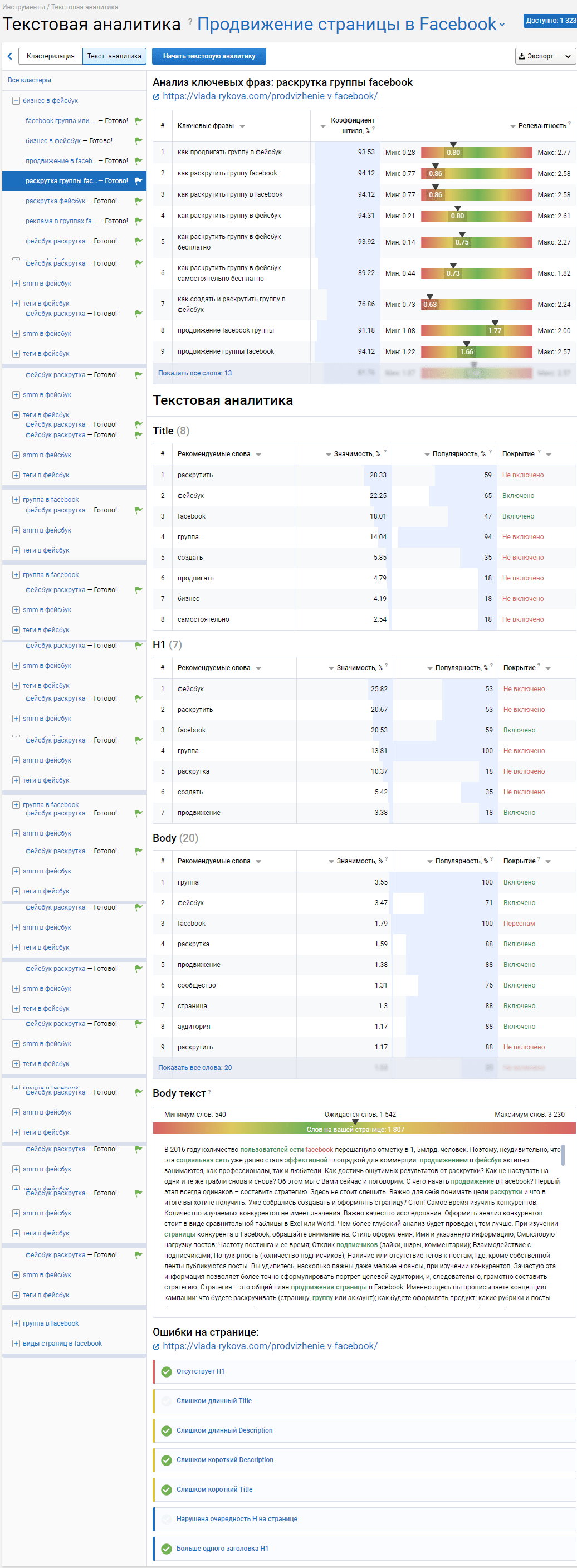

Для прикладу я взяла одну з найбільш відвідуваних сторінок блогу – «Просування сторінки в Facebook».

1. Спочатку створюємо проект в Serpstat.

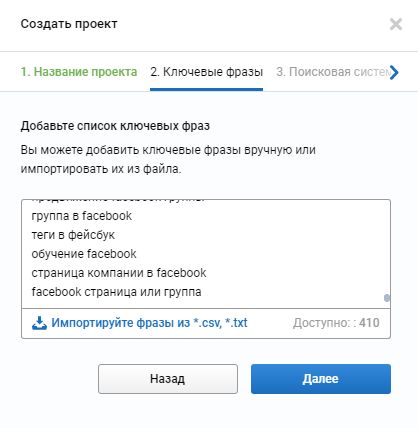

2. Вводимо список ключових фраз для аналізу (вони у Вас повинні були бути ще на етапі збору семантичного ядра).

Якщо ж у Вас немає списку ключових слів, знову ж таки, Вам на допомогу Serpstat.

- Подивіться по яким фразам зараз Ваша сторінка знаходиться в ТОПі, вивантажите цей список.

- Подивіться список упущених фраз і теж вивантажите цей список.

- Обидва списки завантажте в створюваний проект.

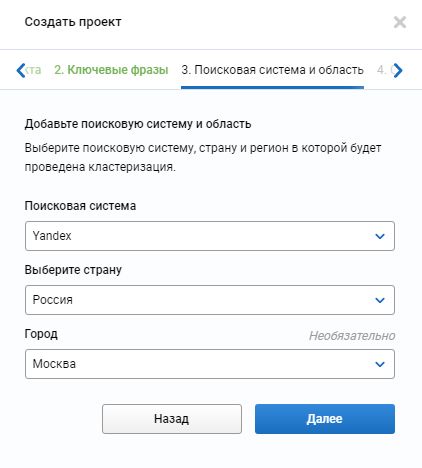

3. Вибираємо налаштування пошукової системи.

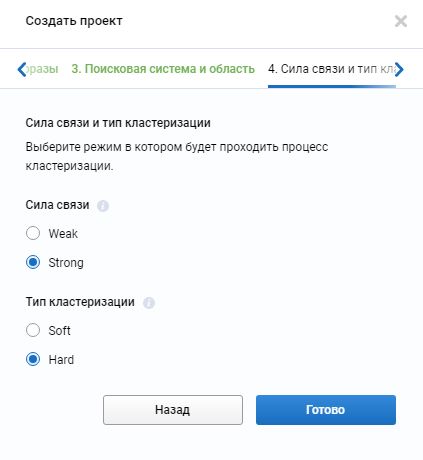

4. Сила зв’язку і тип кластеризації. З цього питання читайте більше в статті – «Кластеризація запитів»

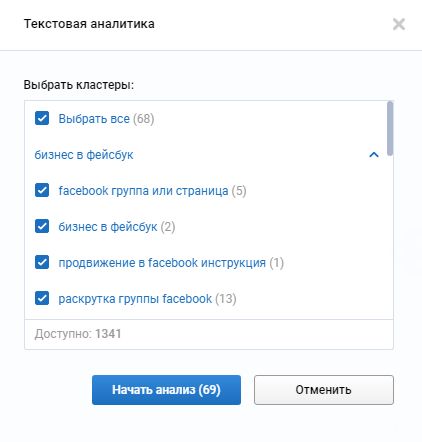

5. Після того, як всі кластеризовано, натискаємо кнопку «Текстова аналітика» і вибираємо кластери. Я вибрала все.

6. Далі в розрізі кожного кластера можна проаналізувати Вашу статтю, додавши її url.

7. В результаті ви отримаєте приблизно такий звіт з рекомендаціями, які слова необхідно включити, по яким йде переспам, а з якими все Ок.

3. Реклама та інструмент Page Layout. Останні дослідження показують, що сайти з великою кількістю рекламних матеріалів у 2016-2017 роках стали рідше відвідувати користувачами. Тут слід згадати про алгоритм Page Layout, який був запущений у 2012 році. Орієнтуватися на нього необхідно і сьогодні.

Довідка: Page Layout – інструмент, який знижує позиції майданчиків з високою щільністю реклами (її, як правило, розташовують у верхній частині сторінки, що тягне за собою зсув основного контенту).

Рішення:

- проведіть аналіз сторінки, з’ясуйте, скільки місця на ній займає реклама;

- якщо їй відведено понад 30-40% простору, то я б рекомендувала знизити цей показник до 20% (також варто звернути увагу на кількість спливаючих рекламних блоків).

4. Швидкість завантаження. Даний параметр важливий для цільової аудиторії сайту. Як і для Google. Пошуковик не хоче, щоб в стрічці результатів були присутні ресурси, які сповільнювали б процес розв’язання користувальницьких задач.

Навесні 2010 року система внесла швидкість завантаження до переліку ключових факторів ранжирування. Сьогодні майданчики, які завантажуються понад 5 секунд, можуть володіти завищеним показником відмов і меншим числом переходів.

5. Мовні параметри. Мовний моніторинг дозволяє пошуковим системам виявляти та розуміти наміри інтернет-користувачів. Ранжування web-проектів у 2021 році буде грунтуватися на реалізації саме цієї процедури.

Нагадаю, що у 2015 році системою був впроваджений алгоритм RankBrain, метою якого є вивчення контексту, суті словесних конструкцій, що розміщуються в межах інформаційних сайтів. Отримані відомості згодом використовуються в рамках підбору оптимального алгоритму видачі релевантних результатів.

Один із застосовуваних пошукачем методів – це виділення мовних шаблонів, які обумовлюють формування максимально продуктивних результатів з урахуванням будь-якого заданого користувачем запиту.

Висновок

Аналіз, а також вивчення особливостей роботи актуальних алгоритмів допоможе вам не тільки грамотно оптимізувати контент на сайті, але і зайняти перші позиції в пошуковій видачі. Удачі вам.

Експерт в області інтернет-маркетингу. Керівник маркетингового агентства MAVR.

Бізнес-ступінь “Майстер ділового адміністрування” (MBA).