Аналіз логів сайту за допомогою Screaming Frog SEO Log File Analyser

У наш час не всі здатні проаналізувати логи сайту, а тим більше вручну (як це робилося раніше). Але іноді це зробити необхідно і навіть дуже корисно, адже працюючи з логами ви стикаєтеся з первинною інформацією: кожне відвідування сайту роботом і людиною відображається в них повністю.

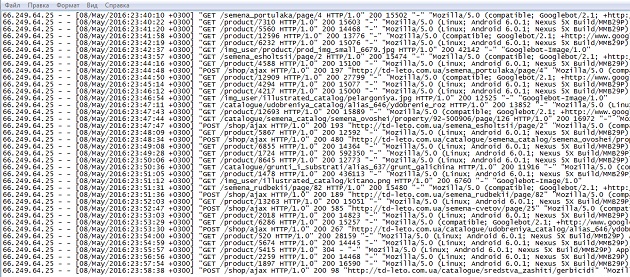

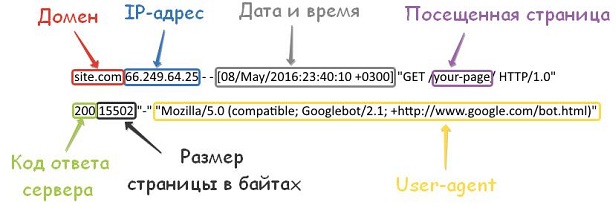

Що ж вони можуть розповісти? Розгляньмо на прикладі. Ось як виглядає одна строчка з журналу:

- домен;

- IP-адреса, з якого був перехід;

- точний час відвідування запиту;

- сама сторінка, яка була відвідана краулер;

- код відповіді, з якими стикаються і роботи, і люди;

- розмір сторінки в байтах;

- user-agent – ім’я клієнта, який звернувся до сервера, за допомогою якого можна дізнатися який браузер і робот звертався до сторінки.

А тепер уявіть, як виглядають логи, які містять не пару відвідувань, а кілька сотень, а то і тисяч відвідувань робота.

Дуже складно аналізувати такі дані вручну, чи не так? Я не кажу, що це неможливо. Ось тільки витратите на цей аналіз ви дуже багато часу.

На щастя, зараз вже є маса інструментів для аналізу логів сайту, як платних, так і безкоштовних. Переглянувши кілька з них, я зупинилася на інструменті від Screaming Frog – SEO Log File Analyser. Саме йому і присвячений мій сьогоднішній огляд.

Інструмент платний: 1 ліцензія – 99 $ на рік. Але є і безкоштовна версія, яка має деякі обмеження:

- 1 проект;

- Всього 1000 рядків в журналі подій;

- Відсутня безкоштовна технічна підтримка.

Дізнатися більш детальну інформацію і завантажити програму можна тут.

Якщо думаєте, що програма зробить все за вас, то ви помиляєтеся. Так, вона зробить велику частину роботи, тобто збере всі дані в купу і представить їх у зручному і зрозумілому вигляді. А вам залишиться найголовніша задача – проаналізувати ці дані, зробити висновки і скласти рекомендації.

Що ж все-таки робить цей інструмент?

- Визначає проскановані URL: дізнайтеся, які саме посилання Googlebot і інші пошукові роботи можуть сканувати, коли і як часто.

- Показує частоту сканування: дізнайтеся які сторінки пошукові роботи відвідують найбільш часто і скільки URL-адрес скануються щодня.

- Знаходить непрацюючі посилання і помилки: показує всі коди відповідей, непрацюючі посилання і помилки, з якими роботи пошукових систем зіткнулися при скануванні сайту.

- Перевіряє наявність редиректів: знаходить тимчасові і постійні редіректи, з якими стикаються пошукові роботи.

- Допомагає оптимізувати краулінговий бюджет: покаже ваші найбільш і найменш часто проскановані URL, з метою виявити втрати і підвищити ефективність сканування.

- Знаходить неотскановані урли і сторінки-сироти: можна імпортувати список URL-адрес і порівняти їх з даними логів для виявлення невідомих сторінок або URL-адрес, які Googlebot не в змозі обробити.

- Дозволяє об’єднати і порівняти будь-які дані.

Отже, приступимо. Думаю, з установкою програми у вас не виникне проблем. Тому переходимо до основного етапу – завантаженнями.

Імпортувати можна 2 види даних:

- лог-файли;

- список URL (в excel форматі).

Для початку, розповім, як імпортувати файли логів.

Перш за все, вам буде потрібно дістати з сервера лог-файли (access.log) вашого сайту. Вони часто зберігаються в папці / logs / або / access_logs /, і через FTP ви можете завантажити ці файли на ваш комп’ютер.

Для того, щоб у вас було достатньо даних для аналізу, я б порекомендувала використовувати лог-файли за місяць.

Після того як ви їх завантажили просто натискаєте кнопку “Import” і вибираєте пункт «Log file».

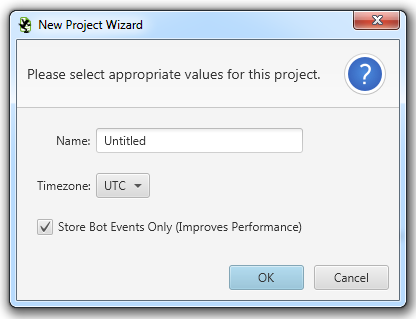

Далі після завантаження даних, вам потрібно буде придумати назву проекту (тут робіть як зручно, головне щоб потім було зрозуміло) і вибрати часовий пояс.

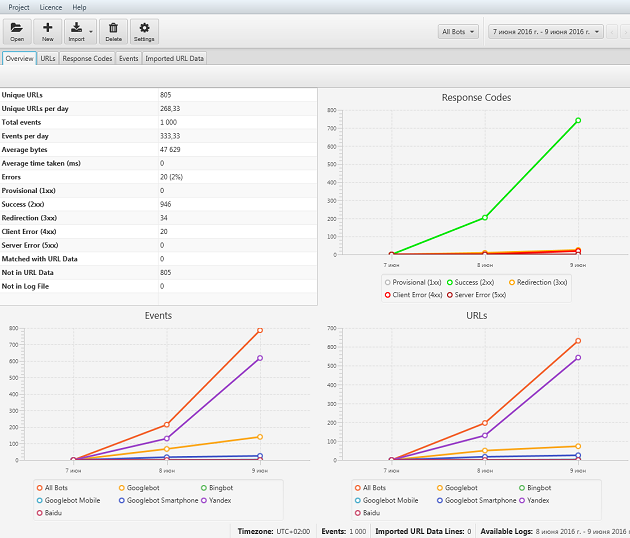

Після цього з’явиться головне вікно панелі управління:

Після цього з’явиться головне вікно панелі управління:

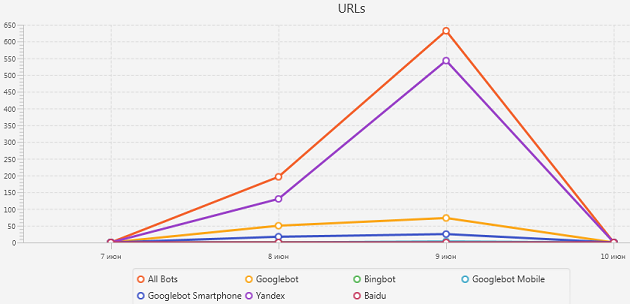

Тут ви можете відразу побачити, які пошукові роботи заходили на ваш сайт і як часто, скільки сторінок вони відвідують і т.д.

Після цього ви можете переходити до глибшого аналізу. Наприклад, можна визначити, які URL-адреси найбільш повільно завантажуються, а які дуже часто відвідуються.

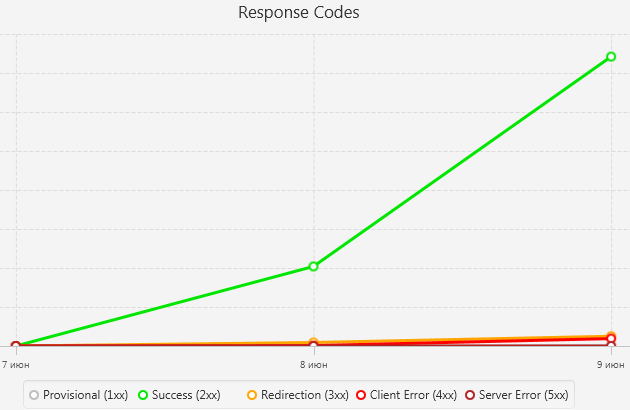

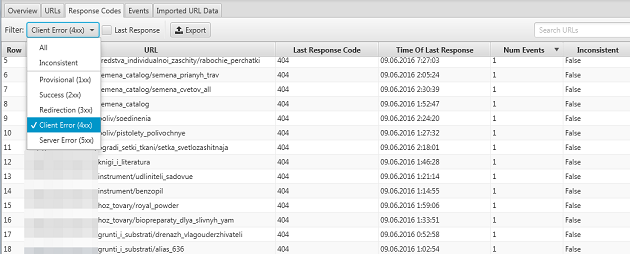

Також можна побачити які коди відповідей віддають посилання. Для цього переходите на вкладку «Response Codes», де у вас є можливість відфільтрувати урли по типу коду. Таким чином, ви можете знайти помилки.

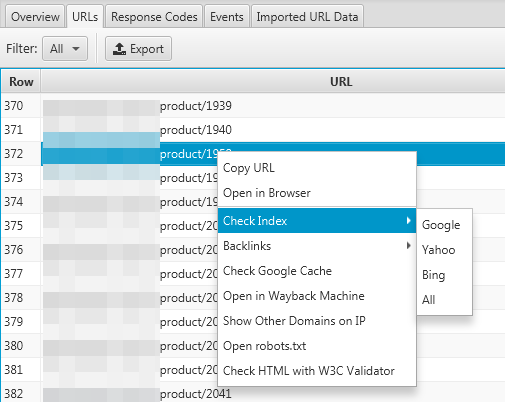

А також я виявила цікаву штуку ☺ При натисканні правою кнопкою на посилання з’являються такі можливості:

- Копіювати посилання;

- Відкрити урл в браузері;

- Перевірити на наявність в індексі ПС (Google, Yahoo, Bing);

- Переглянути зовнішні посилання, що ведуть безпосередньо на цю сторінку;

- Відкрити файл robots.txt і ін.

Повний список ви можете побачити на наступному скриншоті:

Скопіювати і відкрити посилання це звичайно стандартні речі. А ось перевірити на наявність в індексі або однією кнопкою перейти до robots.txt – це вже цікаво. А головне, дуже зручно.

Тепер розповім про другий спосіб імпорту – завантаження списку URL в excel форматі. Навіщо це потрібно подумаєте ви?

У програмі є можливість імпортувати URL-адреси з різних джерел і об’єднати їх з файлом логів для складнішого аналізу. Після того як ви їх імпортували програма може показати URL-адреси, які збігаються або не збігаються в цих наборах даних.

При такому порівнянні ви можете проаналізувати сайт для цілого ряду різних питань:

- Які сторінки на вашому сайті відвідуються найчастіше? Або якісь сторінки не відвідувалися роботом взагалі?

- Чи всі URL-адреси з XML-карти сайту робот відвідав? Якщо ні, то чому?

- Як часто оновлення карти сайту перевіряються роботом?

- При зміні сторінки, скільки часу пройде від повторного обходу до моменту, коли індекс пошуку оновиться?

- Як впливає нові посилання на швидкість сканування?

- Як швидко знову запущений сайт або розділ сайту буде просканований?

І багато інших питань.

Потенціал для аналізу практично не обмежений. Порівнюючи будь-які дані, ви можете отримати значуще уявлення про взаємодію вашого сайту з пошуковими роботами. А це, своєю чергою, дозволяє виявити проблеми на вашому сайті, які інші SEO-інструменти не змогли б так просто знайти.

Отже, в цілому можна сказати, що лог-файли містять величезну кількість інформації, яка може допомогти вам проаналізувати продуктивність вашого сайту і уникнути деяких помилок. А Screaming Frog SEO Log File Analyser допоможе вам в цьому аналізі.

Руководитель SEO-отдела маркетингового агентства MAVR. 4 года опыта в SEO.

Имеет опыт в сферах: beauty, спорт, рекламные услуги и т.д.

Количество проектов: более 94